|

[内存带宽制约系统性能]

FB-DIMM近乎是一种梦幻级的内存技术,在现有技术基础上实现跨越式的性能提升,同时成本也相当低廉。

在整个计算机系统中,内存可谓是决定整机性能的关键因素,光有快的CPU,没有好的内存系统与之配合,CPU性能再优秀也无从发挥。这种情况是由计算机原理所决定的,CPU在运算时所需要的数据都是从内存中获取,如果内存系统无法及时给CPU供应数据,CPU不得不长时间处在一种等待状态,硬件资源闲置,性能自然无从发挥。

反之,倘若拥有一个高效的内存系统,CPU从发出请求到获取数据等待时间非常短暂,那么便可将更多的资源用于实际运算处理,对应的性能自然也就越高。正因为如此,包括Intel、AMD在内的CPU厂商才会充分考虑到内存的配合问题,目前Intel正积极推广高带宽的DDR2内存,而AMD则直接把内存控制器整合于CPU内部,达到降低延迟时间的目的。尽管方式不同,但最终目的都是为了让CPU平台能够发挥出更卓越的效能。

和PC机相比,服务器系统对内存性能更加渴求。服务器要承担的任务量远甚于PC,大量的突发访问、高强度的数据传输、频繁的数据交换、从不间断地稳固运转,这一切都要求服务器系统拥有极高的性能,多处理器往往是标准配备,与之对应,大容量、高速度的内存系统也至关重要。为此,服务器在内存方面往往不惜血本。在许多应用中,4GB容量、双通道设计只是入门产品的基准,在针对敏感应用的多路服务器系统中,多达几十GB甚至上百GB容量也寻常可见。但即便如此,内存依然是服务器性能提升的瓶颈,使用的也仍然是传统的DDR技术。

无论针对何种应用的服务器,单路系统还是多路系统,ECC Registered DDR400内存便是所能达到的最高水平(DDR2刚开始推广,尚未达到普及的水平),它的有效带宽只有3.2GBps,与PC内存没有什么差异。即使使用双通道技术,也只能达到6.4GBps的水平。为了解决这个问题,RISC架构的高端服务器系统大多为每一个CPU都配备了专属性的内存资源,再通过高速总线实现资源共享,这样单CPU便可拥有6.4GBps内存带宽,至于8路的整套系统,有效内存带宽就可以达到51.2GBps的高水平,很好满足了当前应用的需要。

[内存设计思想的变迁]

然而,这种做法只能暂时解决问题,很难应对未来的发展需求,而且容易反过来对CPU的设计造成制约。举个例子,双通道DDR400最多只能提供6.4GBps带宽,那么CPU前端总线带宽也不应超过这个水平,内存系统跟不上,前端总线再快也没用,实际性能还是取决于较慢的内存。我们可以看到,现在不管Itanium 2、Xeon、Opteron还是其他的处理器,前端总线一般都没有高过这个水平。到明年初DDR2-533标准可望成为主流,CPU的前端总线带宽也将几乎同步提升到对应的8.5GBps。但如果CPU厂商想通过提高前端总线来获得更高的性能,唯一的做法就是选择具有更高性能的内存系统。在索尼的PS3中,IBM为其研发的CELL处理器就与四通道Rambus XDR 3.2GHz配合,有效前端总线可达到25.6GBps的高水平,远远超过现有任何一种处理器。

那么,为什么DDR体系在速度上如此滞后?根本原因还应归结于并行设计架构。标准的DDR、DDR2模组都采用64位结构,一次可传输64bit二进制数据,所对应的是64位并行的内存总线。然而,由于先天限制,并行总线很难实现跨越性的性能提升。首先,并行总线很容易相互干扰,令传输信号不稳定,频率很难迅速提升,我们所看到内存规格按部就班地缓慢提升并不仅仅是针对市场消费考虑,更多是技术现实使然;其次,内存模组发送出的并行数据要求在同一个传输节拍中同步到达接收端,这就要求主板PCB中的64条线路长度保持严格一致(主板上采用蛇形方式布线就是为了达到这个目的),这就对PCB设计提出苛刻的要求。而随着内存频率不断提升,允许的线路长度误差越来越小,最终将导致设计线路成为不可能完成的任务—从这个趋势来看,并行内存的发展空间有限,最终必然会朝向窄位宽和串行化的方向发展;第三,同样由于布线的原因,DDR体系最多只能实现双通道,而这就必须用到128条数据线路,占据大量的PCB面积。即使非要实现4通道,主板也没有这么多PCB空间可以利用,数据同步化问题会带来更多的困扰。种种缺陷造成DDR体系速度提升缓慢,即便未来的DDR3也谈不上有多好的表现,依然会保持缓慢升级的速度。

最先挑战这个问题的是Rambus公司,它最初提出的RDRAM内存实际上就是采用窄位宽、高频率的设计思想来提升性能,但过高的成本和糟糕的商业策略葬送了这项优秀技术的市场前景。2003年,Rambus在此基础上发展出更先进的XDR内存,依然基于此种设计思想,一举将内存系统的带宽提升到19.6GBps以上(四通道XDR 2.4GHz),最高可达到100GBps的超级水平(八通道XDR 6.4GHz)。但可惜的是,XDR同样无法摆脱高成本的困扰,未来它的应用领域也许只能局限于索尼PS3游戏机或者IBM基于CELL处理器平台的计算机产品。那么,能否在现行DDR体系基础上,改用串行思想来设计低成本的高性能模组呢?

Intel独家开发的FB-DIMM技术对此作了肯定的回答。FB-DIMM最大的特点就是采用已有的DDR2内存芯片,但它借助一个缓冲芯片将并行数据转换为串行数据流,并经由类似PCI Express的点对点高速串行总线将数据传输给CPU。据悉,FB-DIMM可以在现有DDR2-533基础上轻易实现25.2GBps的高带宽,而该标准的内存系统在明年即可面市。若采用DDR2-800颗粒,FB-DIMM的带宽将进一步提升到38.4GBps,而它的带宽极限可突破57.6GBps—尽管这个数字仍然逊于XDR系统,但它的优点在于成本升高极为有限,是一项廉价的技术。

Intel推出FB-DIMM显然不是为PC所准备,这项技术将首先应用在服务器系统中,Intel的Itanium平台将首先从FB-DIMM受益。现在,就让我们走进FB-DIMM世界,向大家揭示这一项堪称神奇的新技术。

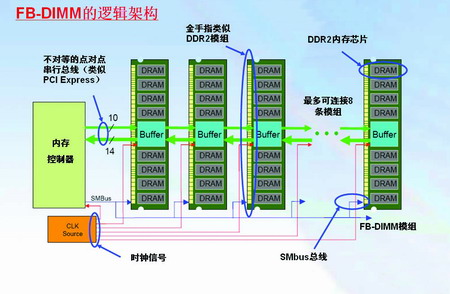

[FB-DIMM的逻辑架构]

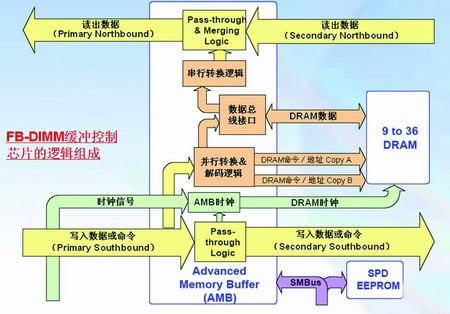

FB-DIMM的全称是“Fully Buffered DIMM(全缓存模组技术)”,大家从其名称中便可直观了解到它的设计思想。如上面所述,FB-DIMM其实就是在一个标准DDR2内存基础上,增加了一枚用于数据中转、读写控制的缓冲控制芯片。该枚芯片承担着以下几方面的任务:第一,负责管理FB-DIMM的高速串行总线,承担数据发送和接收的指派任务,这包含一组数据读取的14位串行通路和一组用于数据写入的10位通路;第二,实现并行数据与串行数据流的翻译转换工作—我们知道,缓冲芯片从内存中读取出来的原始数据原本都为并行格式,它们在通过高速串行总线发送出去之前就必须先转换为对应的串行数据流,而这个任务也必须由缓冲芯片来完成,反之,从内存控制器传来的串行数据流要转成指定的并行格式,然后才能写入到内存芯片中,缓冲芯片自然也要承担这个任务;第三,缓冲芯片必须承担多个模组的通讯联络任务,如果在一个内存通道中存在多条FB-DIMM模组,那么各个FB-DIMM模组间的数据都是通过缓冲芯片来传递、转发的。不难看出,缓冲芯片实际上是FB-DIMM的大脑,它承担所有的控制、传输和中转任务。

使用串行总线作为传输媒介,FB-DIMM便顺理成章拥有跨越式的高接口带宽。根据1.0版标准定义,FB-DIMM模组的串行总线有3.2GHz、4.0GHz和4.8GHz三种频率规格,而每条模组的有效位宽为24bit,所对应的接口带宽便是9.6GBps、12GBps和14.4GBps,远远超过了现有的DDR2内存。不过,如果你认为这就是FB-DIMM的实际性能,那你就错了,FB-DIMM的接口带宽与实际读写带宽其实是两个概念,前者所指的只是每个模组串行总线的最高带宽,它在含义上类似串行ATA接口—串行ATA的总线带宽达到150MBps,但这并不是指串行ATA硬盘能达到这个速度,代表的只是带宽的最高值。同样,FB-DIMM的接口带宽同样如此,模组的实际性能仍取决于内存芯片规格和模组位宽设计。如果采用DDR2-533芯片、64bit位宽设计,那么这条FB-DIMM的有效带宽仍然只有4.2GBps,同现有的DDR2-533内存完全一样。FB-DIMM之所以能拥有高性能,关键在于串行传输技术让它摆脱了并行总线难以实现多通道设计的问题,使得在计算机中引入六通道设计成为可能,借此达到传统DDR体系难以想象的超高带宽,这就是FB-DIMM的真正奥秘所在。

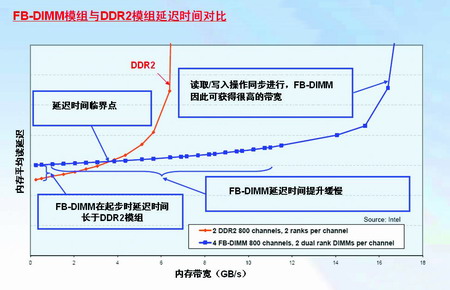

不过,引入缓冲设计也会产生一个新的问题。数据在传输过程中需要经过缓冲和转换,不可避免需要花费额外的延迟时间,对性能产生负面影响。但随着工作频率的提升,这个缺陷会变得越来越不明显。为了保持信号稳定,DDR2内存的延迟时间将随着工作频率的提高而快速增加,而FB-DIMM的延迟时间增幅平缓,所以虽然现在FB-DIMM延迟较高,但当单条模组的带宽达到4GBps左右时,FB-DIMM与DDR2内存延迟时间相当,超过这个临界点之后,DDR2内存的延迟时间将明显长于FB-DIMM。换句话说,FB-DIMM系统不仅具有更高的数据带宽,而且延迟时间更短、反应速度更快。

[FB-DIMM的中枢神经]

串行总线设计是FB-DIMM赖以拥有高效能的基础。实际上,Intel并没有另起炉灶从零开始设计,而是直接沿用了许多来自于PCI Express的成果,其中最关键的就是使用差分信号技术(Differential Signaling)。

关于差分信号技术,此前我们在介绍串行ATA、HyperTransport和PCI Express总线时都有过多方探讨,这里不妨进行简单重述。我们知道,现有各种并行总线都是以一条线路来传输一个数据信号,高电平表示“1”,低电平表示“0”,或者反过来由低电平表示“1”,高电平表示“0”。单通道结构的64bit内存需要使用64条金属线路来传输数据,双通道就需用到128条线路。当数据在线路传输时,很容易受到电磁环境的干扰,导致原始数据出现异常,如高电平信号电压变低,或低电平的电压变高,这些干扰都有可能让接收方作出错误的判断,导致数据传输失败。过去业界曾为这个难题大伤脑筋,当初硬盘数据排线从40针提高到80针细线(增加40根地线)就是为了降低传输干扰,但直到串行技术引入后问题方告解决。

与传统技术迥然不同,差分信号不再是以单条线路的高低电平作为“0”和“1”的判断依据,而是采用两条线路来表达一个二进制数据—数据究竟为“0”还是“1”取决于这两条线路的电压差。这样,即使受到严重的外来干扰,导致两条线路传输的电平信号发生较大范围的电压波动,但它们之间的电压差依然可以保持相对稳定,接收方便能够作出正确的判断。因此,差分信号技术拥有非常强的抗干扰能力,但因它需要占用两条线路,很难被引入到并行总线技术中,只有针对服务器应用的SCSI总线是个例外。

FB-DIMM借鉴PCI Express技术的第二个地方,就是其串行总线也采用了点对点结构。目前,DDR体系的并行总线无法在同一时刻同时发送和接收数据,二者根据指令轮流进行。然而FB-DIMM却可以在同一时刻同时发送和接收数据,奥秘在于它拥有两个串行通路,一个用于数据发送,一个用于数据接收。与之对应,FB-DIMM的缓存芯片有专用的发送控制逻辑和接收控制逻辑,数据读出操作和写入操作可在一个周期内同步进行。这实际上将内存系统的理论延迟时间缩短了一半,弥补了缓冲处理所造成的损失。较为特殊的是,FB-DIMM的数据发送总线与接收总线是不对等的,发送总线一共有14个线路对,一次向内存控制器发送14bit数据。而接收总线采用10位设计,每次只能够接收10bit数据。笼统地说,单通道的FB-DIMM模组就是24bit设计。这种不对等设计之前没有先例,但它却十分符合内存系统的客观实际。在大多数情况下,CPU从内存中读出的数据总是远远多于写入到内存的数据,与之对应,读取总线带宽高于写入总线的设计方案科学合理,而且十分经济。

[文章录入员:onlychao] |